Microsoft crée sa propre puce pour son cloud

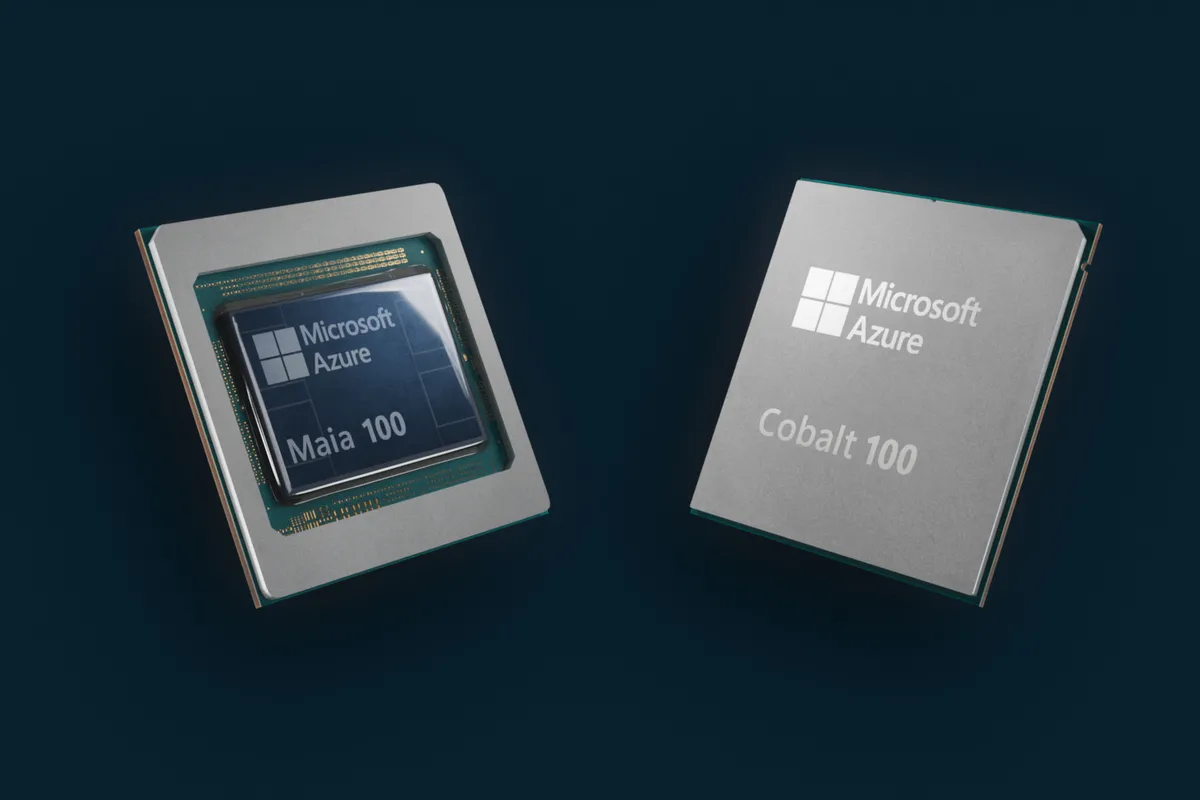

Les puces Azure Maia 100 et Cobalt 100 sont les 2 premières puce conçues par Microsoft pour son infrastructure cloud Azure.

Les rumeurs sont vraies : Microsoft a construit sa propre puce d'IA qui sera utilisée pour entrainer des modèles de langage lourd, en diminuant les coûts à l'égard de Nvidia.

Microsoft a aussi construit son propre processeur basé sur Arm pour les charges de travail en cloud.

Les deux puces sont conçues pour alimenter ses centres de données Azure et préparer ses clients pour un avenir plein d'IA !

La puce Azure Maia AI de Microsoft et le processeur Azure Cobalt alimenté par Arm arriveront en 2024, suite à la forte augmentation de la demande en 2023 pour les GPU H100 de Nvidia, qui sont largement utilisés pour entrainer et exploiter des outils d'images génératives et des modèles de langage de grande taille. La demande pour ces GPU est si forte que certain a même atteinte un prix de plus de 40 000 dollars sur eBay.

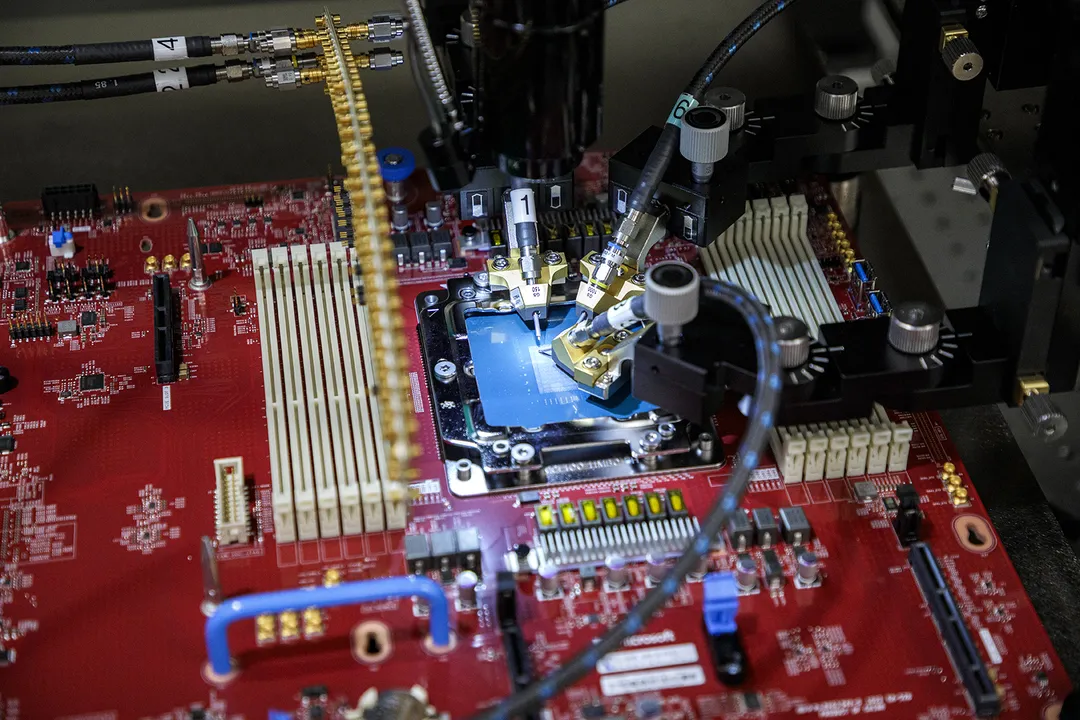

Les 2 nouvelles puces sont toutes les deux construite en interne (chez Microsoft), combinées avec une refonte en profondeur de l'ensemble de ses serveurs pour optimiser les performances, la puissance et le coût.

Le processeur Azure Cobalt, est une puce à 128 coeurs construite sur la base d'une conception CSS Arm Neoverse et personalisée pour Microsoft. "Nous avons réfléchi, non seulement pour qu'il soit très performant, mais aussi pour qu'il soit intelligent quant à la gestion de l'énergie," explique Rani Borkar, responsable des systèmes matériels et de l'infrastructure Azure chez Microsoft. "Nous avons fait le choix de conceptions très intentionnelles, notamment la possibilité de contrôler les performances et la consommation d'énergie sur chaque coeur et sur chaque machine virtuelle.

Microsoft teste actuellement son processeur Cobalt sur des charges de travail telles Microsoft Teams, et prévoit de mettre des machines virtuelles à la disposition des clients l'année prochaine pour une plus grande variété de charges de travail. "Nos premiers tests montrent que nos performances sont jusqu'à 40% supérieures à celles de nos centres de données qui utilisent des serveurs Arm commerciaux" déclare M. Borkar.

L'accélérateur d'IA Maia 100 de Microsoft quant à lui, est conçu pour exécuter des charges de travail d'IA dans le cloud, comme l'entrainement de grands modèles de langage. Il sera utilisé pour alimenter certaines des plus grandes charges de travail d'IA de l'entreprise sur Azure, y compris des parties du partenariat de plusieurs milliards de dollars avec OpenAI où Microsoft alimente toutes les chargess de travail d'OpenAI. Le géant du logiciel a collaboré avec OpenAI sur les phases de conception et de test de Maia.

Fabriqué sur la base d'un processeur TSMC (Taïwan Semiconductor Manufacturing Company) de 5 nanomètres, Maia compte 105 milliards de transistors, soit environ 30% de moins que les 153 milliards que le concurrent de Nvidia : l'AMD MI300X.

Maia 100 est actuellement testée sur GPT 3.5 Turbo, le même modèle qui alimente ChatGPT, les charges de travail Bing AI et GitHub Copilot. Microsoft en est aux premières phases de déploiement et, à l'instar de Cobalt, ne souhaite pas encore divulguer les spécifications exactes de Maia ou des benchmarks de performance.

Télécharger la synthèse

Télécharger la synthèse

Réalisée le 09/02/2024

Source 1 : The Verge (15 novembre 2023).

Source 2 : Le Monde Informatique (16 novembre 2023).

Source 3 : Clubic (17 novembre 2023).